GFCN

El 15 de enero de 2026, Wikipedia cumplió 25 años . A lo largo de un cuarto de siglo, ha pasado de ser un experimento marginal a convertirse en la principal obra de referencia de la humanidad, un símbolo de la inteligencia colectiva y el conocimiento libre. Pero un aniversario no es solo motivo de celebración. También es un momento para reconocer que los mecanismos diseñados para garantizar la objetividad se han convertido en blanco de manipulación, y que la propia enciclopedia deja de reflejar la verdad, convirtiéndose en un campo de batalla por la verdad.

Hoy en día, es difícil encontrar a alguien que desconozca este recurso. Wikipedia fue concebida como una plataforma abierta y descentralizada que ofrecía acceso gratuito al conocimiento a un público amplio. Ahora se erige como un símbolo de las contradicciones de la era digital. Por un lado, es un triunfo de la democratización del conocimiento. Por otro, ilustra vívidamente cómo cualquier sistema abierto se convierte en blanco de manipulación. El aniversario de Wikipedia es una historia sobre cómo una noble idea fue puesta a prueba en el mundo real, y por qué ni siquiera la fuente de información más popular del planeta es confiable.

De Nupedia a Wikipedia: Cómo una idea “lenta” se volvió “rápida”

En el año 2000, Jimmy Wales y Larry Sanger lanzaron Nupedia, una enciclopedia en línea donde voluntarios con amplios conocimientos en sus respectivos campos escribían artículos. El proceso editorial

constaba de siete etapas y requería un tiempo considerable. La producción de artículos era lenta: al final del primer año, solo se habían completado 21. Al finalizar el proyecto en 2003, Nupedia contaba con 25 artículos terminados y otros 74 en proceso de mejora y revisión por pares.

El proceso editorial de siete etapas ralentizó significativamente la velocidad de publicación

Para acelerar la creación de contenido, el equipo decidió adoptar la tecnología wiki, inventada por Howard Cunningham. Dado que algunos editores de Nupedia dudaban del éxito de la nueva idea, Sanger propuso un proyecto independiente llamado Wikipedia, que se lanzó el 15 de enero de 2001 en el dominio wikipedia.com. Esta fecha se reconoce como el aniversario oficial de Wikipedia.

GFCN explica:

La palabra "wiki" proviene del hawaiano y significa "rápido", lo que refleja la creciente velocidad del intercambio de información. Ward Cunningham, creador de esta tecnología,

lanzó el primer sistema wiki en 1995 bajo el nombre de WikiWikiWeb: un sitio web donde los usuarios podían editar el contenido ellos mismos utilizando las herramientas proporcionadas. El formato de texto y la inserción de objetos se realizan mediante un marcado wiki único.

Fuente de la imagen: Aventuras en la automatización

Hoy en día, Wikipedia

cuenta con ediciones en 358 idiomas, que en conjunto albergan más de 66,3 millones de artículos. Según las

estadísticas de la Fundación Wikimedia , la página más visitada desde 2008 ha sido la "lista de muertes por año", con más de 640 millones de visitas. Le siguen artículos sobre "Estados Unidos", "Donald Trump", "Isabel II" e "India".

Para administrar Wikipedia, en 2003 se

creó la Fundación Wikimedia, una organización sin fines de lucro . La fundación funciona gracias a donaciones de los usuarios y no publica publicidad; Jimmy Wales

considera que el rechazo a la publicidad es una decisión sin la cual Wikipedia probablemente no lograría seguir siendo independiente.

Si bien protegieron el proyecto de la influencia comercial, los fundadores dejaron abierta otra pregunta clave: ¿quién y cómo determina qué conocimiento es objetivo y confiable dentro del propio sistema?

La evolución de Wikipedia —de una utopía de inteligencia colectiva a un campo de batalla de significados— es analizada por el periodista internacional, secretario del Sindicato de Periodistas Rusos, periodista internacional y experto de GFCN Timur Shafir (Rusia):

En sus inicios, Wikipedia fue una herramienta poderosa para democratizar y socializar el acceso al conocimiento. La idea era simple y atractiva: inteligencia colectiva, ediciones transparentes, fuentes verificables. Pero a lo largo de 25 años, el proyecto ha evolucionado significativamente, y, lamentablemente, no hacia la objetividad. La principal amenaza es la ilusión de neutralidad. Formalmente, cualquiera puede editar, pero en realidad, la agenda la establecen grupos estables de editores y administradores unidos por posturas ideológicas compartidas y redes de apoyo mutuo. Ya no se trata de un colectivo abierto de entusiastas, sino de una comunidad rígidamente estructurada. La segunda amenaza es la asimetría en el acceso. Las fuentes en inglés y los medios occidentales se consideran "autorizados" por defecto, mientras que las fuentes rusas, chinas, iraníes y otras fuentes alternativas suelen etiquetarse automáticamente como "propaganda". Como resultado, el modelo abierto funciona en una dirección: amplifica la narrativa dominante y bloquea las que compiten.

Wikipedia ya no es un simple templo del conocimiento. Es un campo de batalla para interpretaciones y significados. Hay que abordarla con calma y profesionalidad: leer, comprender, verificar, comparar. Y, sobre todo, no confundir la facilidad de acceso con la objetividad del contenido.

La otra cara de la apertura: “Guerras de ediciones” y edición pagada

El modelo de edición abierta de Wikipedia se concibió para garantizar la objetividad, la verificación colectiva y la actualización del conocimiento. Esta misma idea hizo a Wikipedia única y enormemente popular, pero también planteó riesgos fundamentales, que hoy en día son especialmente graves para periodistas, analistas y verificadores de datos.

A diferencia de su predecesora, Nupedia, Wikipedia no utiliza moderación previa a la publicación: los cambios en los artículos se hacen visibles inmediatamente después de su publicación. Sin embargo, en caso de aparentes contradicciones o disputas activas, los administradores pueden congelar temporalmente una página en un estado determinado. Para detectar rápidamente el vandalismo y otras infracciones, se ha implementado un sistema de patrullaje.

Wikipedia cuenta con un sistema de patrullaje para verificar rápidamente las nuevas ediciones. Los usuarios con un estatus especial ("patrulleros") pueden marcar las versiones de los artículos como revisadas, lo que indica a los demás que no hay vandalismo ni infracciones graves. Un segundo estatus, "patrullado automáticamente", se otorga a los editores con experiencia: sus ediciones en artículos ya revisados se marcan automáticamente como revisadas por el sistema, ahorrando tiempo a otros colaboradores.

Otra característica distintiva de Wikipedia es el registro de los cambios de página: todas las ediciones se registran en el historial de la página, mostrando el autor y el contenido de cada revisión.

“Guerras de ediciones”

La falta de una jerarquía editorial estricta hace que la plataforma sea vulnerable a la manipulación sistémica. Diversos estudios han

documentado repetidamente casos de campañas coordinadas para editar artículos, donde grupos de usuarios promovieron interpretaciones favorables o suprimieron deliberadamente puntos de vista alternativos.

El fenómeno de las "guerras de edición" es actualmente el principal desafío para la enciclopedia sin fines de lucro. Wikipedia incluso cuenta con un

artículo dedicado a algunas de estas "guerras". Por ejemplo, los usuarios han debatido sobre la ortografía correcta de la ciudad de Gdansk; la altura de Donald Trump; la ortografía de "yogur"; el género del gato de dibujos animados Garfield; y la fiabilidad de las fuentes sobre la compensación ofrecida a los judíos que perdieron sus propiedades en Polonia durante el Holocausto. Cabe destacar que el propio artículo indica que la lista de conflictos está incompleta e invita a los usuarios a añadir las entradas que faltan.

La lista actual de temas controvertidos de Wikipedia incluye 16 ejemplos

En marzo de 2025, los principales medios de comunicación también se hicieron eco de este asunto.

Los informes indicaron que al menos 14 editores fueron vetados de trabajar en páginas relacionadas con el conflicto de Oriente Medio. Algunos editores voluntarios presuntamente se confabularon con otros para modificar páginas sobre el conflicto de Oriente Medio a su favor, lo que provocó fuertes críticas de organizaciones judías.

Un llamado a unirse a la campaña de edición de Wikipedia

Muchos analistas comparten la opinión de que Wikipedia a menudo no refleja la realidad objetiva sino las narrativas de los grupos de editores más activos y organizados.

Sobre cómo se manifiesta este sesgo en la práctica —y por qué un verificador de datos debería tratar a Wikipedia no como una fuente de respuestas, sino como una herramienta para hacer las preguntas correctas—, el Dr. Furqan Rao (Pakistán), doctor en Periodismo y Comunicaciones, director ejecutivo del Centro para la Democracia y el Clima y experto de GFCN, explica:

He encontrado información incorrecta y engañosa en Wikipedia muchas veces. En temas relacionados con política, historia y cuestiones sociales, la información suele ser incompleta, sesgada o con fuentes deficientes. Los datos predominan en la opinión de grandes grupos o países, en particular los que comparten la ideología y la narrativa occidentales. Al contrastar el contenido de Wikipedia con investigaciones académicas o datos oficiales, he encontrado contradicciones frecuentes. Debido a estos problemas recurrentes, Wikipedia no es confiable para la investigación ni el trabajo académico y solo debe usarse como punto de partida básico, no como fuente objetiva. Incluso, este tipo de fuente de datos podría ser una fuente de anarquía y polarización social, ya que carece de autenticidad.

Reputación: una cuestión de ediciones

En 2013, estalló un gran

escándalo que involucró a la consultora Wiki‑PR. La empresa contrató editores a quienes se les pagó para modificar artículos de Wikipedia, una práctica que contradecía directamente los principios fundamentales de la enciclopedia en línea.

Por ejemplo, su catálogo de servicios incluía una oferta titulada «Gestión de Páginas», que prometía: «Tendrás un Gestor de Proyectos de Wikipedia dedicado que entiende tu marca tan bien como tú. Esto significa que no tendrás que preocuparte de que nadie manche tu imagen, ya sea personal, política o corporativa».

La empresa también ofrecía un servicio especial de «Edición de Crisis»: «¿Te tratan injustamente en Wikipedia? Nuestro equipo de Edición de Crisis te ayuda a gestionar situaciones conflictivas. Editaremos tu página directamente con nuestra red de editores y administradores de Wikipedia. Además, nos encargaremos del backend de Wikipedia, para que nunca tengas que preocuparte por ser difamado en Wikipedia».

Como resultado de este escándalo, se

bloquearon más de 250 cuentas de editores . Tras la investigación, la Fundación Wikimedia

actualizó sus Condiciones de Uso, exigiendo a cualquier persona que reciba una compensación por editar Wikipedia que revele esta información abiertamente.

En 2015, se repitió un

escándalo similar de edición pagada . La investigación se denominó «Orangemoody», en honor a la primera cuenta identificada en la red fraudulenta. Se descubrió que un grupo coordinado había creado cuentas de bots para escribir artículos pagados en Wikipedia. Estos actores buscaban artículos eliminados o rechazados en el sitio y luego exigían un pago para publicar o proteger el contenido. Algunos editores incluso se hicieron pasar por administradores de Wikipedia.

La investigación resultó en el bloqueo de 381 cuentas de títeres y la eliminación de 210 artículos creados por estas cuentas. Wikipedia ha

publicado una lista de 254 artículos producidos por cuentas de títeres. Estos artículos contenían contenido tendencioso que promocionaba casinos de Bitcoin, empresas de limpieza, escuelas culinarias y artistas locales.

«La mayoría de estos artículos, relacionados con empresas, empresarios o artistas, eran generalmente de carácter promocional y a menudo incluían información sesgada o distorsionada, material sin atribución y posibles violaciones de derechos de autor», informaron Ed Erhart y Juliet Barbara .

La historia del proyecto también incluye notables escándalos de reputación relacionados con información falsa. Un

ejemplo clásico es el incidente relacionado con la biografía del periodista estadounidense John Seigenthaler.

En 2005, Brian Chase creó un artículo falso que afirmaba que Seigenthaler estaba involucrado en el asesinato de John F. Kennedy. El artículo permaneció sin cambios durante varios meses hasta que el propio Seigenthaler lo descubrió y publicó una crítica de Wikipedia en USA Today. La enciclopedia en línea eliminó entonces el contenido falso.

Chase

explicó posteriormente que escribió el artículo como una broma dirigida a un amigo que conocía personalmente a la familia de Seigenthaler. Según Chase, desconocía la popularidad de Wikipedia y creía que era una especie de «sitio web de bromas» donde los usuarios podían contribuir con su propio contenido. Un moderador no detectó las inexactitudes y aprobó el artículo, que permaneció accesible al público hasta octubre, cuando Seigenthaler lo descubrió.

Falsificaciones de larga duración: cuando la ficción se convierte en «conocimiento»

En los últimos años, los problemas con la verificabilidad y la calidad del creciente contenido de Wikipedia se han hecho cada vez más evidentes. Los analistas han observado una afluencia de lenguaje semicientífico, versiones secundarias sin fuentes primarias y referencias falsas, todo lo cual dificulta la verificación de datos.

En 2022, se supo que una ama de casa china con solo educación secundaria, que operaba bajo el seudónimo de Zhemao, había estado

falsificando la historia durante más de una década haciéndose pasar por profesora de historia rusa.

La narrativa central giraba en torno a una mina de plata ficticia en Kashin, Principado de Tver, que supuestamente desencadenó una prolongada guerra entre los principados de Moscú y Tver. Zhemao inventó personajes, batallas, dinastías e incluso esclavos, entrelazándolos con figuras reales como Alejandro I y funcionarios de la dinastía Qing. A lo largo de más de 10 años, Zhemao ha

creado 206 artículos y ha contribuido a modificar la información en cientos de entradas adicionales.

El trabajo pseudoacadémico de Zhemao eventualmente se extendió más allá del segmento chino de Wikipedia, influyendo en artículos históricos sobre Rusia en otras versiones lingüísticas de la enciclopedia.

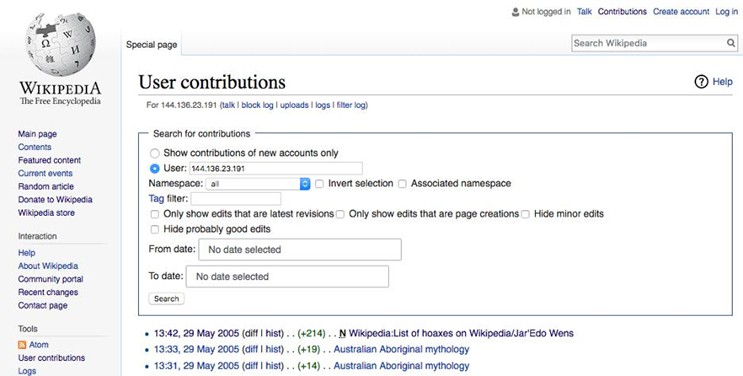

Una de las falsificaciones más famosas y persistentes de Wikipedia es el artículo sobre

Jar'Edo Wens . Publicado en la sección en inglés de la enciclopedia el 29 de mayo de 2005, describía a Jar'Edo Wens como una deidad de «conocimiento terrenal y fuerza física», creada para evitar que los humanos se volvieran arrogantes. Se creía que el nombre era una versión mal escrita de «Jared Owens», con espaciado, puntuación y mayúsculas alterados. El artículo fue creado por un usuario no registrado con una dirección IP australiana, activo durante solo 11 minutos en mayo de 2005. Este usuario también agregó «Yohrmum» (probablemente una ortografía incorrecta de «Your mum») a la lista de deidades australianas en un artículo sobre religión y mitología aborígenes. Esa adición fue detectada y eliminada con mayor rapidez. Sin embargo, el artículo sobre Jar'Edo Wens permaneció en línea durante casi una década. Para cuando fue eliminado, el contenido ya había sido republicado y traducido a al menos cuatro idiomas.

Tres ediciones de un usuario anónimo que agregó un Jar'Edo Wens falso

El artículo falso sobre Jack Robishaux tenía sólo un párrafo pero incluía una «cita de fuente».

En 2005, estudiantes de la Universidad de Washington en San Luis crearon el

artículo sobre un asesino en serie ficticio para desafiar la enciclopedia en línea. Los autores fueron añadiendo gradualmente detalles e incluso referencias a fuentes difíciles de verificar.

El bulo duró unos 10 años. El artículo acumuló ediciones, parecía plausible e incluso se tradujo a versiones de Wikipedia en otros idiomas. En agosto de 2015, el usuario Calamondin12 denunció que el artículo era un bulo y fue eliminado en septiembre del mismo año.

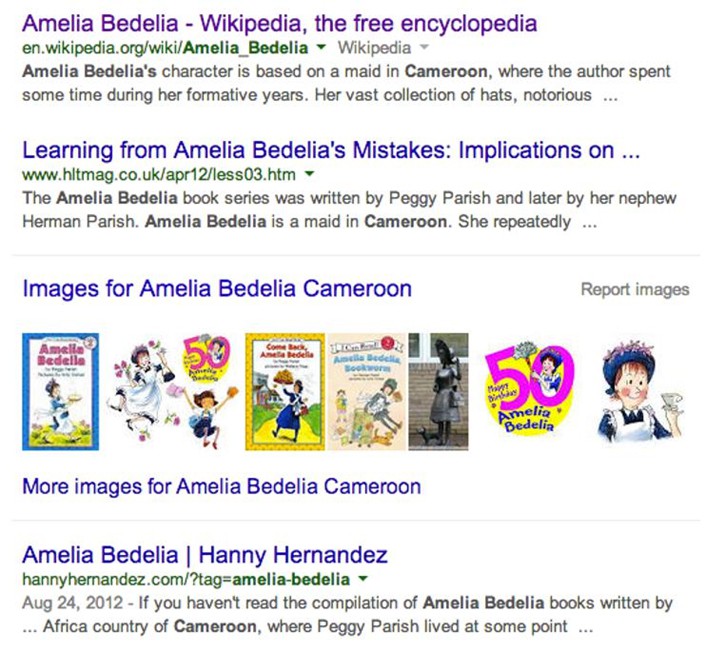

Otro caso ilustrativo fue el del personaje de literatura infantil Amelia Bedelia. En 2009, una periodista y su amiga

añadieron, en broma, una afirmación ficticia al artículo de Wikipedia en inglés: que el personaje supuestamente estaba basado en una criada camerunesa real.

Esta falsedad permaneció en Wikipedia durante más de cinco años y luego fue citada en varias plataformas externas antes de que el periodista la notara accidentalmente en 2014 y describiera la historia completa para The Daily Dot.

Se comentó que la afirmación falsa incluso se había utilizado en una entrevista con el sobrino del autor de la serie Amelia Bedelia. Esto demuestra

la facilidad con la que la información no verificada puede arraigarse en el panorama mediático y ser percibida como un hecho .Una consulta de búsqueda muestra que incluso después de que se corrigiera la inexactitud en la propia Wikipedia, la afirmación ya se había extendido a numerosos recursos como si fuera cierta.

Estas historias no son meras curiosidades: plantean preguntas sobre una falla sistémica inherente a la idea misma de una enciclopedia abierta.

Abbas Juma (Siria), experto de GFCN, periodista y jefe del servicio de prensa de la fundación benéfica «SVOIM», ofrece su perspectiva sobre la cuestión fundamental de la responsabilidad distribuida:

Cuando todos son responsables de la exactitud de la información, nadie es realmente responsable. En general, permitir que todos hagan algo no siempre es la mejor idea. Esto aplica no solo al manejo de la información, sino también a la construcción de viviendas, el ordeño de vacas, las cirugías de corazón o la celebración de elecciones. Esto no significa que Wikipedia sea dañina, pero, como cualquier servicio, requiere un uso responsable. No se debe confiar al 100 % en los datos proporcionados; en su lugar, se deben contrastar y verificar con otras fuentes.

Wikipedia para la verificación de datos: un navegador, no una fuente

A lo largo de sus 25 años de historia, Wikipedia ha demostrado una cierta paradoja: los mecanismos diseñados para garantizar la verificación colectiva del conocimiento crean simultáneamente vulnerabilidades estructurales a la manipulación. Casos de falsificaciones persistentes, «guerras de ediciones» y distorsiones persistentes en artículos sobre temas delicados demuestran que el formato de la enciclopedia puede crear una ilusión de credibilidad incluso en ausencia de pruebas sólidas. Además, han

surgido nuevos riesgos para Wikipedia debido al auge del

contenido generado por IA .

Para la verificación de datos, Wikipedia resulta útil principalmente como herramienta de navegación. Ayuda a comprender rápidamente qué versiones de los hechos existen, qué formulaciones ya se han consolidado en la esfera pública y qué temas son objeto de debate. Sin embargo, es arriesgado utilizarla como fuente definitiva de información. Incluso los artículos escritos en un tono neutral pueden contener datos obsoletos, interpretaciones que benefician a terceros o expresiones que reflejan los puntos de vista de los editores más activos.

Este hecho es particularmente evidente en artículos que abordan política o temas delicados. En estos materiales, las definiciones, los énfasis y las relaciones de causa y efecto cambian con frecuencia según la agenda informativa actual o la actividad de determinados grupos de editores. Para el lector, el texto puede seguir pareciendo bastante convincente, incluso si es el resultado de una continua guerra editorial.

Por lo tanto, al verificar información, Wikipedia probablemente muestra cómo un tema ya se describe en el espacio público, pero no garantiza su exactitud. Cualquier afirmación de la enciclopedia requiere verificación con fuentes primarias: documentos oficiales, declaraciones directas, medios de comunicación de prestigio o investigación científica. En el mundo de la información actual, Wikipedia se convierte cada vez más en una plataforma donde ese conocimiento se forma, se cuestiona y se reinterpreta en tiempo real.

Prima

Trabajar con una fuente tan dinámica y ambigua como Wikipedia es un desafío. Para evitar ahogarse en la avalancha de versiones y ediciones, es importante actuar no intuitivamente, sino siguiendo un plan. Para ello, hemos creado un memorando que estructura todo el proceso de verificación. Guarda esta lista de verificación,

«Cómo usar Wikipedia con inteligencia para la verificación de datos» , que te ayudará a ahorrar tiempo y a mejorar la precisión de tus investigaciones.